Version [80405]

Dies ist eine alte Version von VorstellungLVQ erstellt von SebastianThomas am 2017-06-22 09:28:37.

Die Vorstellung der LVQ-Familie

A. Einleitung

Die Lernende Vektorquantisierung (LVQ, learning vector quantisation) ist ein künstliches neuronales Netz und besitzt eine einschichtige Topologie. Die Neuronen lernen nach dem Wettbewerbsprinzip. Das Neuron mit der höchsten Ähnlichkeit zu dem eingegebenen Merkmalsvektor gewinnt den Wettbewerb und nur auf dieses wird die Lernregel angewandt, welche relativ einfach ist. Das Verfahren benötigt wenig Rechenleistung und wenig Hauptspeicher und ist deshalb für empirische Parameteroptimierungen, bei denen extrem viel gelernt und verworfen werden muss, sehr gut geeignet. Die weiteren nachfolgenden Ausführungen orientieren sich an einem Vorlesungsmanuskript [Golz, 2016] und an einer Abschlussarbeit eines Kommilitonen [Zapf, 2016]. Unter allen Algorithmen der LVQ-Familie stellt sich immer wieder OLVQ1 als leistungsstärkster heraus, dieser verwendet für jedes Neuron eine individuelle Lernschrittweite und hat deshalb einen etwas höheren Hauptspeicherbedarf. Offenbar ist die Anpassung der Lernschrittweite ein wichtiges Element des Erfolgs. Im nächsten Abschnitt werden Methoden vorgestellt, die die Anpassung der Lernschrittweite noch mehr verfeinern. OLVQ1 wird als bevorzugte Methode für die empirische Optimierung der gesamten Prozesskette und für die Bruteforce-Selektion von Merkmalstypen verwendet. Entscheidend für den Erfolg ist eine geeignete Initialisierung der Gewichtsmatrix, hierfür wurde 1998 von der Hochschule Schmalkalden eine Methode entwickelt [Golz et al., 1998]. Die Anzahl der Neuronen wird dabei vorgegeben und zufällig datengetrieben initialisiert. Während des Initialisierungsverfahrens können sich einige Neuronen als tote Neuronen herausstellen, diese werden vor dem Start des Lernverfahrens gelöscht. Das Löschen toter Neuronen ist ein entscheidendes Konzept um Überanpassung (overfitting) zu vermeiden.

B. Generalisierendes Relevanzlernen

Die nachfolgenden Ausführungen lehnen sich an das Kapitel 11.5 des Vorlesungsskripts „Computergestützte Intelligenz, Teil 1“ der Hochschule Schmalkalden an [Golz, 2016]. Wenn eine Klassifikation präzise gelingt, stellt sich stets die Frage, welche Merkmale hierfür sehr hilfreich und welche weniger hilfreich waren. Dabei ist anzunehmen, dass auf die weniger hilfreichen verzichtet werden könnte, ohne Beeinträchtigung des Klassifikationerfolges. Es gibt Lernverfahren, die die Relevanz der Merkmale unter Berücksichtigung der Klassenentscheidung eigenständig lernen. Dabei gibt es Lernregeln für die Relevanzfaktoren, welche die Wichtigkeit der einzelnen Merkmale beschreibt. Ein Konzept ist die Verwendung der Relevanzfaktoren in einer gewichteten Metrik unter Einbeziehung der gewichteten Euklid’schen Distanz.

formel

\overline xformel

undformel

\overline yformel

seien zweiformel

dformel

-dimensionale Merkmalsvektoren undformel

r_1formel

bisformel

r_dformel

seien die Relevanzfaktoren der einzelnen Dimensionen vonformel

\overline xformel

bzw.formel

\overline yformel

, dann werden diese wie folgt als Gewichtungsvektoren eingesetzt.formel

d=\|\overline x - \overline y\|=\sqrt[2]{r_1(x_1-y_1)^2+r_2(x_2-y_2)^2+...+r_d(x_d-y_d)^2}formel

Die Relevanzfaktoren

formel

r_1formel

bisformel

r_dformel

bilden einen Vektor der so normiert wird, dass die Summe ihrer Komponenten, also die Summe der Relevanzfaktoren, gleich eins ist. Dadurch können alle Relevanzen prozentual interpretiert werden. Unter allen relevanzlernenden Algorithmen der LVQ-Familie soll hier vor allem die Generalisierte Relevanz-LVQ (GRLVQ) [Hammer & Villmann, 2002] vorgestellt werden. Folgende Algorithmen werden ebenfalls vorgestellt.Eine Arbeitsgruppe der TU Graz entwickelte Distinction Sensitive-LVQ (DSLVQ) [Pregenzer et al., 1994]. Eine japanische Arbeitsgruppe führte das Konzept der Generalisierten LVQ (GLVQ) [Sato & Yamada, 1995] ein. Aus der Arbeitsgruppe von Hammer wurde daraufhin das Konzept der Relevanz-LVQ (RLVQ) [Bojer et al., 2001] eingeführt.

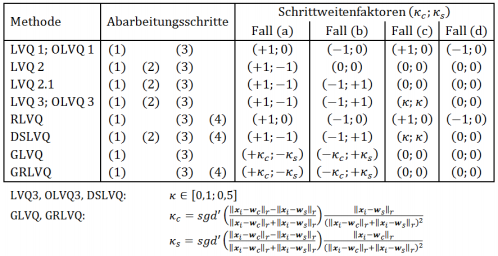

Folgende vier Abarbeitungsschritte sind bei allen, hier vorgestellten LVQ-Algorithmen durchzuführen. Diese Abarbeitungsschritte laufen zyklisch ab, sodass immer nach Schritt 4 der Zyklus mit Schritt 1 startet, wobei ein neues, aktuelles Datenpaar von Merkmalsvektor

formel

\overline {x_i}formel

und Klassennummerformel

t_iformel

aus der Trainingsmenge entnommen wird. Der Zyklus wird abgebrochen, wenn die Anzahl der Iterationenformel

nformel

, die hier die Zyklusanzahl ist, einen von vornherein festgelegten Schwellwertformel

n_{max}formel

überschreitet.1) Neuronenwettbewerb

1.1)

Mit der gewichteten Distanz

formel

\|\overline {x_i}-\overline {w_j}\|_\overline rformel

wird der erste und zweite Gewinner berechnetformel

(\overline {w_c},d_c)formel

bzw.formel

(\overline {w_s}, d_s)formel

. Der Indexformel

cformel

bedeutet „closest“ und bezeichnet den Gewichtsvektorformel

\overline wformel

, der die geringste Distanz zum aktuellen Merkmalsvektorformel

\overline {x_i}formel

hat. Der Indexformel

sformel

bedeutet „second closest“ und bezeichnet den Gewichtsvektor mit der zweitgeringsten Distanz zum aktuellen Merkmalsvektor. Die Klassennummer, die den Neuronen in der Initialisierungsphase fest zugeordnet wurde, wird mitformel

dformel

bezeichnet.

1.2)

Bezüglich der Klassennummer sind vier Fälle möglich

Hier bezeichnet

formel

t_iformel

die fest zugeordnete Klassennummer des aktuellen Merkmalvektorsformel

\overline {x_i}formel

1.3)

Nun sind die Schrittweitenfaktoren

formel

(K_c, K_s)formel

gemäß Tabelle 1 auszuwählen, wobei die vier Fälle (a) bis (d) aus 1.2) zu berücksichtigen sind. Die Tabelle enthält zusätzlich die ausführenden Abarbeitungsschritte je nach Methode, die eingangs erwähnt wurden.

Man ersieht aus Tabelle 1, dass die Schrittweitenfaktoren größtenteils konstant sind, wobei die Konstante Null bedeutet, dass sich keine Gewichtsvektoränderung ergibt und deshalb die Lernregel nicht angewandt werden muss. Bei positiven bzw. negativen Konstanten wird der Gewichtsvektor so verändert, dass das Neuron vom aktuellen Merkmalsvektor angezogen

bzw. abgestoßen wird. Die Algorithmen GLVQ und GRLVQ verwenden jedoch variable Schrittweitenfaktoren, sie sind also adaptiv und hängen von den Distanzen der beiden gewinnenden Neuronen vom aktuellen Merkmalsvektor ab. Die Formeln hierzu sind unterhalb der Tabelle vermerkt und wurden von Sato et al. bzw. Hammer und Villmann hergeleitet. Dabei bedeutet

formel

sgd'formel

die erste Ableitung der Sigmoidfunktion.2) Gehe zu Schritt 3., falls

2.1)

in 1.2) der Fall (a) oder (b) vorliegt und

2.2)

der aktuelle Merkmalsvektor

formel

\overline {x_i}formel

in einem hyperbolischen Fenster zwischenformel

\overline {w_c}formel

undformel

\overline {w_s}formel

liegt.

Andernfalls gehe zu Schritt 1) und wähle den nächsten aktuellen Merkmalsvektor aus der Trainigsmenge aus.

3) Anwendung der Lernregel für beide gewinnende Gewichtsvektoren nach den folgenden Formeln.

4.1) Aktualisierung der Relevanzfaktoren nach folgenden Relevanzlernregeln.

GRLVQ:

formel

r_k=r_k^0- \eta_r sgd'(\xi \frac{\|x_i-w_c\|_r-\|x_i-w_s\|_r}{\|x_i-w_c\|_r+\|x_i-w_s\|_r}) \xi \frac{\|x_i-w_s\|_r(x_{i,k}-w_{c,k}^2)-\|x_i-w_c\|_r(x_{i,k}-w_{s,k}^2)}{(\|x_i-w_s\|_r+\|x_i-w_c\|_r)^2}formel

mit

formel

p_k=\xi \frac{|x_{i,k}-w_{s,k}x_{i,k}-w_{c,k}|)}formel

4.2) Schwellwertvergleich, um negative oder zu kleine Relevanzwerte zu verhindern.

DSLVQ:

formelr_k=\left\{\begin{array}{c} 1, r_k \gt 1 \\ 10^{-4},r_k \lt 10^{-4} \\ r_k, \textrm{sonst}\end{array}\right.formel

4.3) Normierung des Relevanzvektors

RLVQ: formelr^0=\frac{1}{\ | r\ | _2}rformel

GRLVQ: formelr^0=\frac{1}{\ | r\ | _2}rformel

DSLVQ: formelr^0=\frac{1}{\ | r\ | _1}r,p^0=\frac{1}{\|p\|_1}pformelC. Literatur

zurück zum Hauptartikel |

Diese Seite wurde noch nicht kommentiert.